Deepchecks

免费 + $7/月 起Deepchecks 提供专业的 LLM 应用评测与监控工具,助力高效发布高质量 AI 应用。

1 次使用

English

访问网站

https://www.deepchecks.com访问deepchecks

DeepchecksDeepchecks 提供专业的 LLM 应用评测与监控工具,助力高效发布高质量 AI 应用。https://www.deepchecks.comWebApplication

免费 + $7/月 起CNY

NovaTools

关于此工具

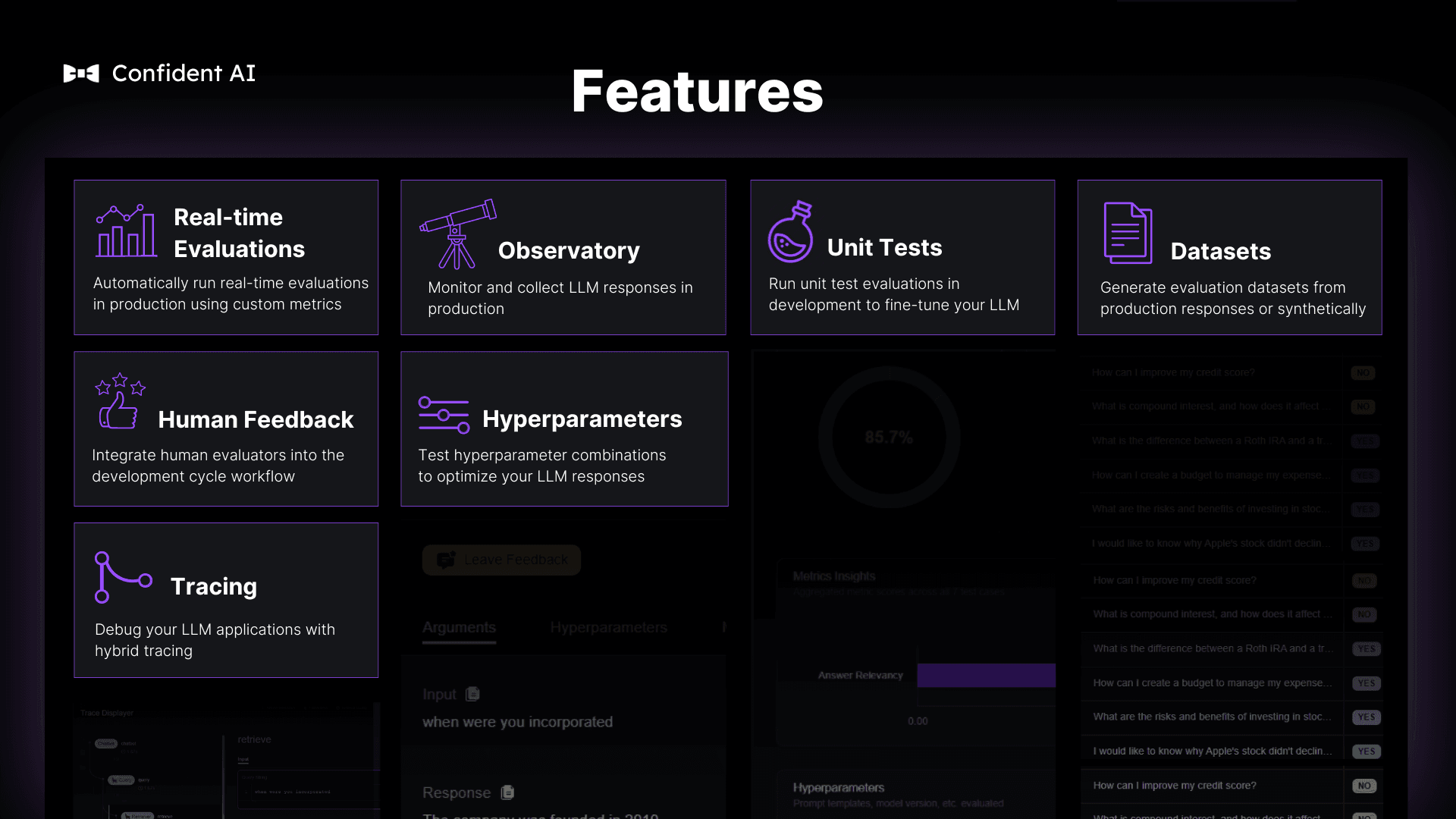

Deepchecks 是一款专注于大型语言模型(LLM)应用评测与监控的工具平台,帮助团队在开发、CI/CD 流程及生产环境中快速验证 LLM 应用性能。通过自动评分、版本比较及定制化数据集生成,Deepchecks 有效降低评测复杂性,提高创新效率,并支持生成式 AI 的主观结果评估。

工具截图

核心功能(5)

自动评分与性能验证

支持在开发和生产阶段自动评分 LLM 输出,帮助团队快速识别低质量或偏差结果。

多版本对比

可以轻松比较不同模型、提示词及代理的版本表现,优化决策流程。

定制化数据集与 LLM 裁判

快速生成用于评测的专属数据集,并创建 LLM 裁判,实现精细化评估。

生产环境监控

持续监控 LLM 应用在生产中的表现,及时发现异常或质量下降问题。

支持 CI/CD 流程集成

可在持续集成和交付管道中嵌入评测流程,加速高质量 LLM 应用上线。

应用场景(5)

1

LLM 应用上线前测试

在开发阶段使用 Deepchecks 对模型输出进行自动评分与性能验证,确保上线质量。

2

版本选择与优化

比较不同模型和提示词版本的结果,帮助团队选择最佳方案。

3

生成式 AI 结果评估

通过 LLM 裁判和定制数据集,对生成式 AI 的主观输出进行科学评估。

4

生产环境持续监控

实时监控部署的 LLM 应用,发现低质量输出或异常行为,保障业务稳定。

5

数据注释与切片分析

利用自动评分进行数据注释和细分分析,为数据驱动的决策提供支持。

替代工具推荐

替代工具推荐

为您推荐功能相似或互补的AI工具,帮助您找到更适合的解决方案