Confident AI

暂无定价Confident AI是基于DeepEval的LLM评估与可观测性平台,帮助工程团队测试、基准测试、保障并提升大型语言模型应用的性能。

关于此工具

工具截图

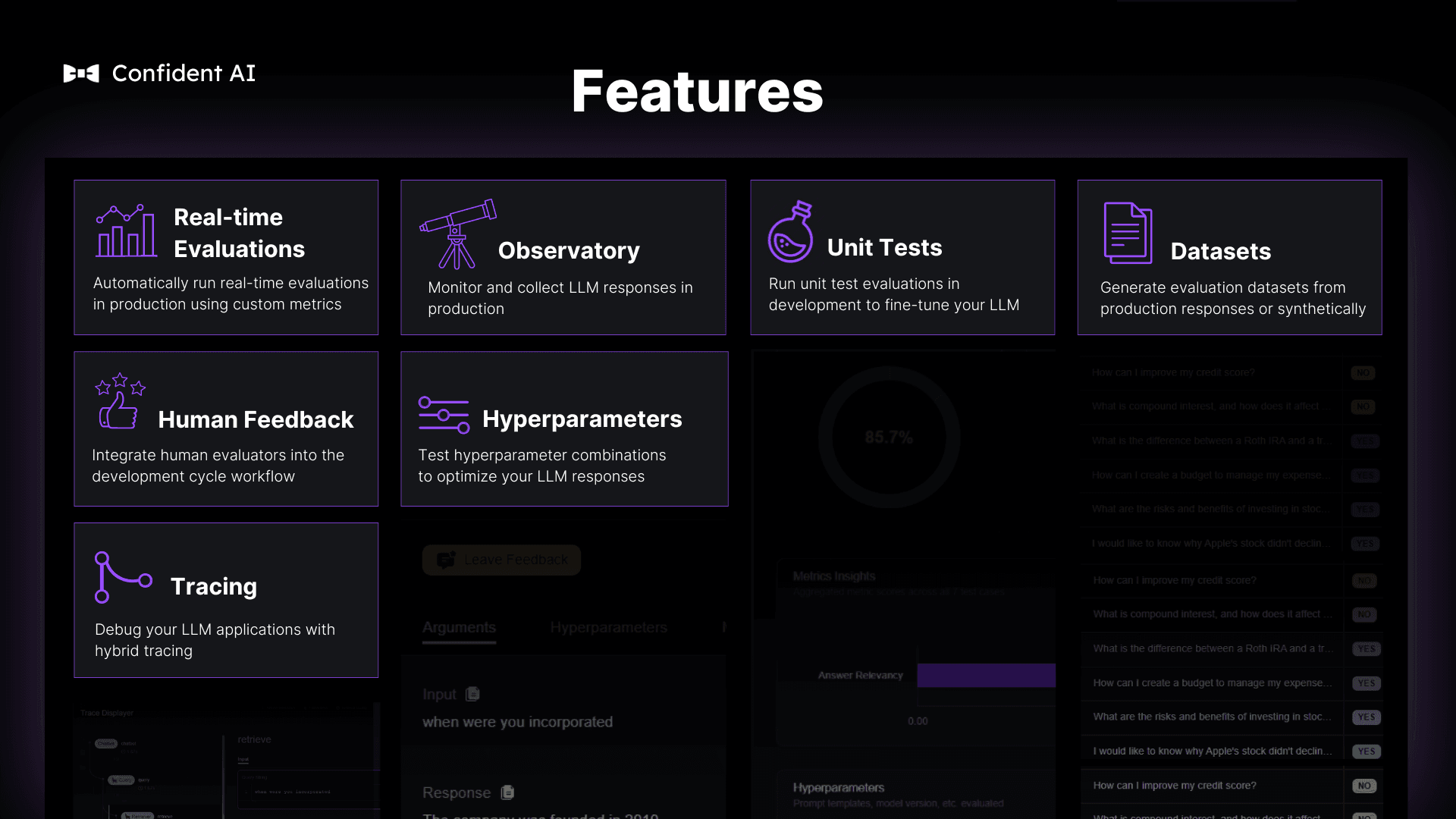

核心功能(4)

LLM评估与基准测试

利用DeepEval的强大指标,对LLM系统进行全面评估和基准测试,优化模型和提示词,并及时捕捉性能退化。

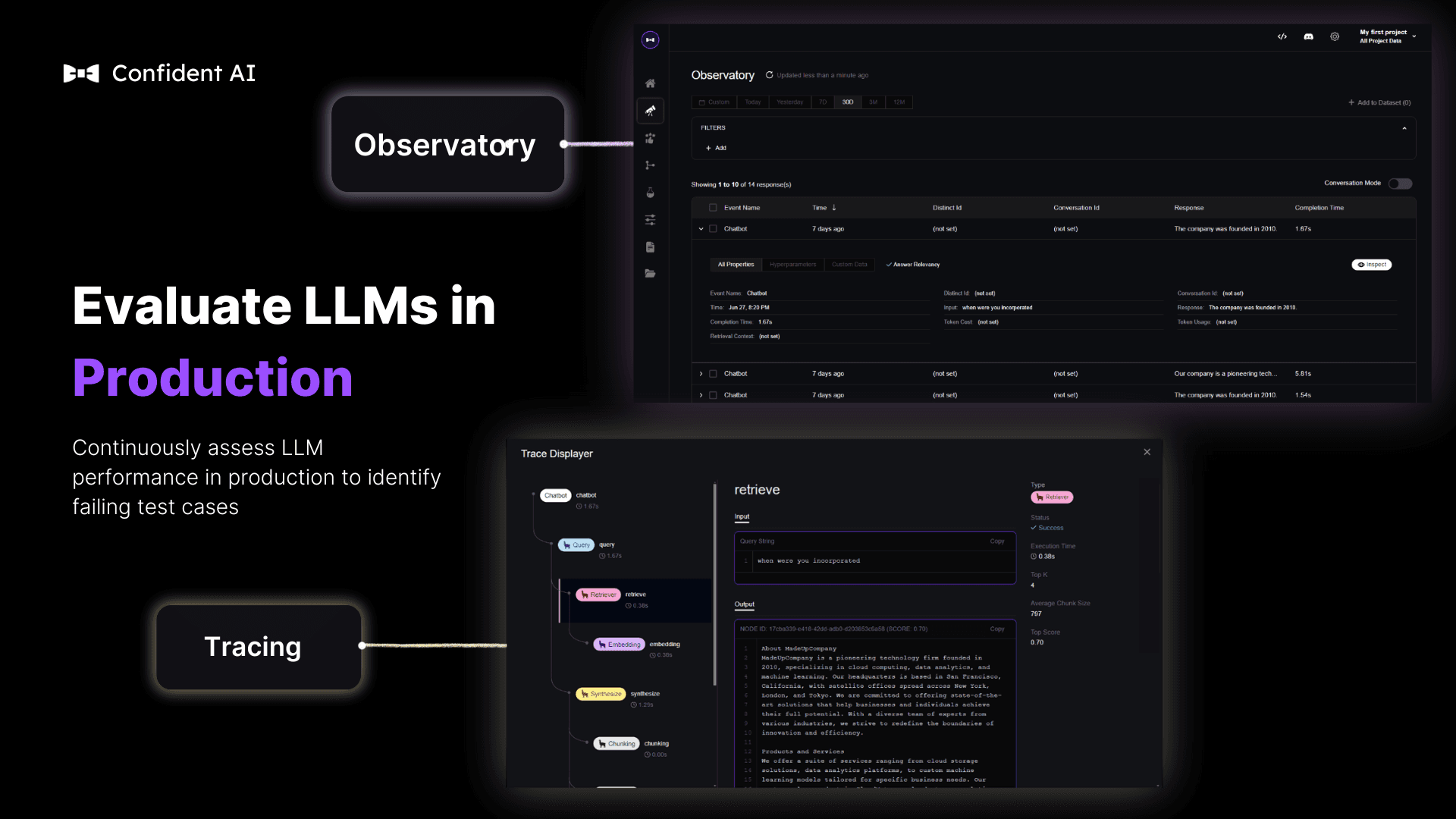

全面的LLM可观测性

提供生产环境实时性能洞察,支持监控、追踪和A/B测试,确保LLM应用在高压下依然表现卓越。

AI系统安全防护

通过自动化的LLM测试和追踪,有效保障AI系统的稳定性和可靠性,每周为团队节省数百小时的调试时间。

开源且备受信赖

作为开源项目并获得Y Combinator支持,已被全球顶级公司广泛使用,拥有超过30万次日评估量和10万次月下载量。

应用场景(3)

优化LLM应用性能

工程团队可以使用Confident AI来优化其大型语言模型应用的性能,确保模型的输出质量和响应速度。

提升AI系统稳定性

通过持续的评估和可观测性,帮助团队保障AI系统的稳定性,减少生产环境中的意外故障和回归问题。

高效管理LLM开发流程

为AI开发团队提供规范化的评估解决方案,包括数据集管理、指标校准和自动化测试,从而构建强大的AI护城河。